März 2021

QAR-Lab im Themenheft „Quantencomputing“

der DIGITALE WELT

04.03.2021 – Die neue Ausgabe der DIGITALE WELT ist jetzt erhältlich und umfasst ausgewählte Expertenbeiträge zum aktuellen Themenschwerpunkt Quantum Computing. Auf einer fachlichen Ebene konnte das QAR-Lab die Redaktion bei der Erstellung des Hefts unterstützen. Hier können Sie die Ausgabe kostenlos lesen.

04.03.2021 – Die neue Ausgabe der DIGITALE WELT ist jetzt erhältlich und umfasst ausgewählte Expertenbeiträge zum aktuellen Themenschwerpunkt Quantum Computing. Auf einer fachlichen Ebene konnte das QAR-Lab die Redaktion bei der Erstellung des Hefts unterstützen. Hier können Sie die Ausgabe kostenlos lesen.

Auftaktveranstaltung des Munich Quantum Valley (MQV) – QAR-Lab am Bayerischen Verbundnetzwerk mit beteiligt

04.03.2021, München – Am 4. März 2021 fand der Auftakt zur Initiative Munich Quantum Valley (MQV) statt. Ziel der Initiative ist es, Bayern und Deutschland zu einem großen Hub für Forschung und Entwicklung in diesem wichtigen Zukunftsfeld zu machen. In den kommenden zehn Jahren will der Verbund Munich Quantum Valley die Entwicklung der Quantenwissenschaft und -technologie weiter vorantreiben. Zu den Gründern des Netzwerks gehören neben der Ludwig-Maximilians-Universität München die Bayerische Akademie der Wissenschaften, die TUM, die Fraunhofer-Gesellschaft und die Max-Planck-Gesellschaft.

Corona-bedingt fand der offizielle Auftakt virtuell statt. Die geladenen Gäste waren Vertreter aus der Politik, die Präsidenten der beteiligten Institutionen und Industrievertreter. Die Beteiligten wurden in Videokonferenzen und Videobotschaften zugeschaltet.

Die Begrüßung übernahmen Hubert Aiwanger (Bayerischer Staatsminister für Wirtschaft, Landesentwicklung und Energie), Bernd Sibler (Bayerischer Staatsminister für Wissenschaft und Kunst), Bernd Huber (Ludwig-Maximilians-Universität München), Thomas Höllmann (Bayerische Akademie der Wissenschaften), Thomas Hofmann (Technische Universität München), Reimund Neugebauer (Fraunhofer-Gesellschaft) und Martin Stratmann (Max-Planck-Gesellschaft).

Prof. Dr. Claudia Linnhoff-Popien erläuterte als eine der Beteiligten am Munich Quantum Valley in einer Videobotschaft, dass ihr Informatik-Lehrstuhl der LMU bereits heute Zugriff auf vier Quantencomputer habe und für das Munich Quantum Valley Software und Anwendungen entwickle sowie diese mit ihren zahlreichen Anwenderfirmen verprobe.

In der zweistündigen Eröffnung wurden verschiedene Aspekte des Munich Quantum Valley vorgestellt: der 3-Punkte-Plan, Standort & Infrastruktur, Quantenhard- und –software sowie Anwendungen und der Technologietransfer.

Neben den Gründungsmitgliedern sollen weitere wichtige bayerische und nationale Forschungseinrichtungen und Universitäten mit starken Aktivitäten im Bereich Quantenwissenschaft und -technologien effizient mit dem MQV verbunden werden und an dessen Aktivitäten teilnehmen. Aufgrund der Stärke seiner Gründungsinstitutionen und der langfristigen institutionellen Finanzierung will der MQV eine Schlüsselrolle in einer nationalen und europäischen Quantenstrategie spielen.

Quantencomputing… Warum eigentlich?

Lothar Borrmann

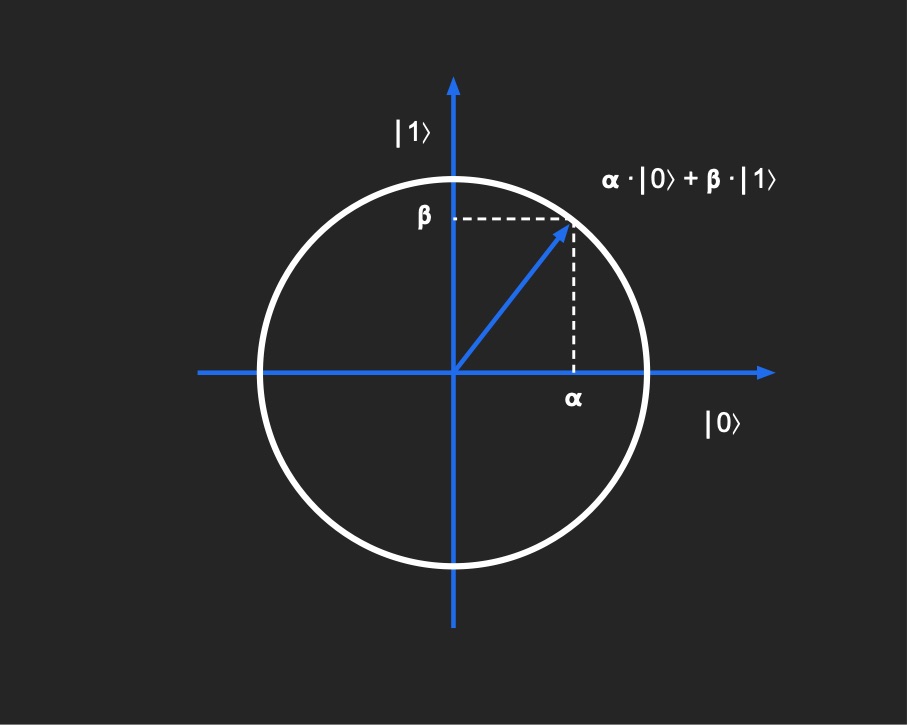

Abbildung: Die Superposition als Vektor

Über etwa sechzig Jahre hat sich die Leistungsfähigkeit klassischer Digitalrechner immer weiter gesteigert – Gordon Moore lässt grüßen! Mittlerweile stoßen wir hier jedoch an physikalische Grenzen. Und bei aller Performance lassen sich mit unseren Computern manche Aufgabenstellungen, zum Beispiel bei der Lösung von Optimierungsproblemen, nicht wirklich berechnen. Wir begnügen uns da bisher mit Näherungslösungen.

In dieser Situation kann man nur noch mit einem Paradigmenwechsel weiterkommen.

Quantencomputer (QC) sind ein solcher Paradigmenwechsel. Ihre Funktionsweise basiert nicht auf Bits, die deterministisch den Wert 0 oder 1 haben, sondern auf Qubits. Das Qubit ist eine elementare Informationseinheit, die nur durch die Quantenmechanik korrekt beschrieben wird und die gleichzeitig unterschiedliche Zustände haben kann – Superposition. Und mit einem weiteren Phänomen aus der Quantenphysik, der Verschränkung, lassen sich Informationen austauschen.

Die Funktion eines darauf basierenden Rechners ist radikal anders als wir es von Computern gewohnt sind. Und gerade da liegt der Vorteil. Schon 1994 entwickelte Peter Shore einen Algorithmus zur Primfaktorzerlegung auf Quantencomputern. Er zeigt, dass damit Aufgaben berechenbar werden, die auf konventionellen Rechnern als unlösbar gelten, deren Lösung dort Jahre oder Jahrzehnte dauern würde.

Quantencomputer werden also nicht den Prozessor im Smartphone ersetzen, nicht den PC und auch nicht den Linux-Server in der Cloud. Aber zur Bearbeitung ganz spezifischer Probleme, da versprechen sie einen Durchbruch.

Das Problem des Handlungsreisenden (Traveling Salesman): Ein bekanntes mathematisches Optimierungsproblem. Für eine Reise durch mehrere Städte soll die gesamte Reisestrecke minimiert werden und keine Stadt darf doppelt besucht werden.

Für den produktiven Einsatz solcher Systeme gibt es nun zwei Herausforderungen: Einerseits die Konstruktion eines Quantencomputers mit einer ausreichenden Anzahl von zuverlässig arbeitenden Qubits, die Hardware also, und andererseits die Programmierung eines solchen Computers, die ja ganz anderen Prinzipien folgt als klassische Software.

Bei der Entwicklung der Hardware läuft seit etwa 2015 ein Wettbewerb vieler Player, von Start-ups über Google bis IBM. Und wie üblich bei solchen neuen und unreifen Technologien werden ganz unterschiedliche Ansätze verfolgt.

Die Nutzung solcher experimenteller Maschinen, auch wenn sie in der Cloud zugänglich sind, steht aber fast ausschließlich Forschern und Experten offen. Das QAR-Lab konzentriert sich daher auf die vergleichende Validierung solch unterschiedlicher QC-Architekturen, auf die Entwicklung von Quantensoftware und auf die Lösung real existierender Probleme, um Anwendern einen Migrationspfad anbieten zu können.

Unter Quantensoftware versteht man das breite Spektrum von hardwarenahen QC-Compilern, QC-Schaltkreisen, QC-Algorithmen bis hin zu vollumfänglichen QC-Applikationen. Dazu gehören insbesondere Algorithmen, die wesentliche Merkmale der Quantenmechanik wie Superposition oder Verschränkung bei der Berechnung bzw. dem Lösen von Problemstellungen verwenden, um dann auf Quantencomputern abzulaufen.

Historie des Quantencomputings

Jonas Stein

Quantenmechanik und Quantencomputing: Große wissenschaftliche Revolutionen

Die Entdeckung der Quantenmechanik führte zu einer der größten wissenschaftlichen Revolutionen des 20. Jahrhunderts. Als fundamentale Theorie der Physik beschreibt sie die Eigenschaften atomarer und subatomarer Materie.

Das Ausmaß jüngster Forschungserfolge, deutet nun auf eine zweite Quantenrevolution hin. Eine der zentralen Quantentechnologien ist das Quantencomputing, bei dem quantenmechanische Effekte genutzt werden, um komplexe Probleme zu lösen. Diese Entdeckung liegt Richard Feynman zugrunde, der 1982 erkannte, dass Quantensysteme effizient durch Quantencomputer simuliert werden können. Bis heute sind keine effizienten klassischen Algorithmen im Problemfeld der Quantensimulation bekannt.

Der große Unterschied zwischen klassischen Computern und Quantencomputern ist die Nutzung von Quantenbits anstatt der sonst üblichen Bits. Diese sogenannten Qubits sind das quantenmechanische Äquivalent eines klassischen Bits. Ein Qubit ist ein Zweizustandssystem und befindet sich, solange keine Messungen darauf stattfinden, in einer sogenannten Superposition. Das bedeutet, dass es sich gleichzeitig in beiden der zwei möglichen Zustände befindet und erst durch eine Messung mit einer gewissen Wahrscheinlichkeit entweder in den einen oder den anderen Zustand zerfällt. Eine mögliche physikalische Realisierung eines Qubits ist ein Photon dessen Polarisation anhand zweier orthogonaler Polarisationsrichtungen gemessen wird.

Zwei Ansätze des Quantencomputings: Gate und Annealer

Die zwei Hauptansätze zur Implementierung eines Quantencomputers sind einerseits der Quantum Gate Computer und andererseits der Quantenannealer als approximative Umsetzung des Konzepts von adiabatischem Quantencomputing. Quantum Gate Computer führen ähnlich wie klassische Computer, durch eine Hintereinanderschaltung von Quantengattern (statt der im klassischen Bereich genutzten logischen Gatter) Berechnungen aus. Quantenannealer sind eine komplett andere Form von Quantencomputern und sind durch den Prozess des Annealings aus der Metallurgie motiviert. Dabei wird das Prinzip genutzt, dass physikalische und insbesondere quantenmechanische Systeme stets einem energetischen Minimum entgegenstreben.

Trotz der unterschiedlichen Architekturen sind beide Systeme äquivalent im Hinblick auf die benötigte Rechenzeit zur Lösung algorithmischer Probleme: Jeder Algorithmus, der auf einem Quantum Gate Computer läuft, kann in der gleichen Zeit (schlimmstenfalls erhöht um einen konstanten Faktor bezüglich der Anzahl an genutzten Gattern) auf einem Quantenanneler ausgeführt werden kann und umgekehrt. Um ein beliebiges Problem mit einem Quantenannealer lösen zu können, ist eine Umformulierung in ein quadratisches Optimierungsproblem ohne Nebenbedingungen nötig. Zusätzlich dazu muss die Optimierungsvariable als binäre Zahl kodiert sein, sodass ein sogenanntes QUBO Problem vorliegt.

Quantenalgorithmen und geeignete Probleme

Seit der ersten Idee zu einem Quantencomputer wurden für einige Probleme quantenbasierte Lösungsalgorithmen entwickelt (Algorithmen, die von Quantencomputern ausgeführt werden können), die nachweislich schneller sind, als es jeglicher klassische Algorithmus für diese Probleme je sein könnte. Zusätzlich dazu ermöglichen Quantencomputer die effiziente Lösung von Problemen, die nach aktuellem Stand der Forschung nicht praktikabel von klassischen Computern gelöst werden können. Dazu gehört beispielsweise das Problem der Primfaktorisierung von sehr großen Zahlen, auf dem nahezu alle gängigen Verschlüsselungsmethoden basieren. Sobald die Kapazitäten der Quantencomputer ausreichend angewachsen sind, könnten somit nahezu alle Informationen, die heute über das Internet gesendet werden, entschlüsselt werden. Um dies zukünftig zu verhindern wurden bereits quantensichere Verschlüsselungen entwickelt, jedoch wird es noch einige Jahre dauern, bis diese flächendeckend eingesetzt werden können.

Die neuen Quantentechnologien bieten insbesondere weitreichende Chancen: Mit Hilfe von Quantenkommunikation und Quantenkryptografie kann ein abhörsicheres Quanteninternet aufgebaut werden.

Im Jahr 2019 gelang es erstmals ein Problem auf einem Quantencomputer schneller als auf dem zu der Zeit besten verfügbaren Supercomputer zu lösen. Bei diesem experimentellen Beweis der sogenannten „Quantum Supremacy“ (z. Dt. Quantenüberlegenheit) handelte es sich zwar um ein Problem weit abseits von jeglichen praktischen Anwendungen, aber mit stetig wachsenden Quantencomputern lassen sich zunehmend auch diese realisieren.

Eine Frage, die sich recht schnell nach der Entwicklung von Quantencomputern stellte, war: Existieren Probleme, die mithilfe von Quantencomputern (exponentiell) schneller als mit klassischen Computern gelöst werden? Die Hoffnung, dass Quantencomputer NP-schwere Probleme effizient lösen können, wurde – zumindest bislang – nicht erfüllt. Zwar existieren Algorithmen wie der von Peter Shor zur Primfaktorisierung, die einen exponentiellen Speedup bieten, jedoch befinden sich all diese Probleme in der Komplexitätsklasse der NP-Intermediate Probleme.

Bau eines Quantencomputers

Seit Anfang der 2000er Jahre schreitet der Bau von Quantencomputern zügig voran: nachdem 1998 erstmals ein Quantencomputer mit zwei Qubits realisiert werden konnte, wurde bereits 2011 der erste kommerzielle Quantencomputer, hergestellt von der Firma D-Wave Systems, auf den Markt gebracht. Zu einem Preis von 10 Millionen Euro konnten hier Quantenannealer mit einer Qubitanzahl von 128 erworben werden. Aktuell ist D-Wave Systems eine der wenigen Firmen, die Hardware anbieten. Die meisten anderen Firmen, darunter beispielsweise IBM und Rigetti, verkaufen lediglich Rechenzeit auf ihren Quantum Gate Computern. Die Anzahl an Qubits auf den größten Quantum Gate Computern beträgt aktuell circa 70, während die Quantenannealer von D-Wave Systems bereits über 5000 Qubits verfügen. Das liegt vor allem daran, dass Quantenannealer physikalisch leichter zu realisieren sind als Quantum Gate Computer. Das Hauptproblem beim Bau von Quantencomputern ist die Dekohärenz. Dabei verliert ein Quantenobjekt seine quantenmechanischen Eigenschaften und „zerfällt“ zu einem klassischen Objekt. Dies geschieht, weil Qubits stets mit ihrer Umwelt interagieren, auch wenn dies innerhalb eines Quantencomputers nicht gewollt ist. Deshalb müssen die meisten „Quantum Processing Units“ (QPUs), je nach Prozessorarchitektur, auf eine Temperatur nahe dem absoluten Nullpunkt von 0 Kelvin abgekühlt und elektromagnetisch abgeschirmt werden. Vor allem die individuelle Kühlung jedes einzelnen Qubits bereitet dabei aktuell noch große Probleme.

Ausblick

Bis Quantum Gate Computer über eine ausreichende Anzahl an Qubits verfügen, um gewinnbringend in praktischen Anwendungen zum Einsatz zu kommen, werden noch einige Jahre vergehen. Im wissenschaftlichen Konsens wird dieser Zeitpunkt nicht vor dem Jahr 2025 erwartet. Aber auch wenn dieser Zeitpunkt gekommen ist, dürfte es unwahrscheinlich sein, dass alle Probleme nur noch auf Quantencomputern gelöst werden. Viel wahrscheinlicher sind hybride Algorithmen, die die Vorteile beider Systeme vereinen.